BANGKOK LOOPS

entre analogique et numérique

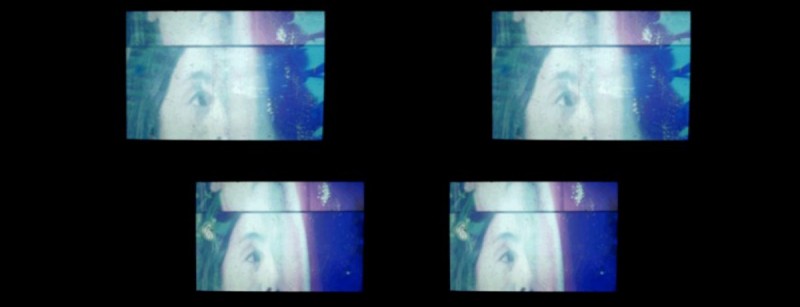

La performance Bangkok Loops présentée au Festival du nouveau cinéma en octobre dernier était un premier test devant public, une sorte de présentation de l’état de nos recherches. Il s’agissait aussi d’une manière de valider la réussite des images trois dimensions créées artisanalement, une façon de confronter les images à une foule de spectateurs, à un éventail de perceptions propres à chaque individu. Est-ce que l’expérience vécue serait commune à chacun ? Est-ce que chaque personne verrait un degré différent de 3D ? C’est dans une atmosphère de projection-test, d’esprit de laboratoire que le son des projecteurs 16mm s’est fait retentir le soir du 9 octobre à l’Agora de l’UQAM…

Du found footage …

Le projet pourrait se résumer par le détournement d’une bande-annonce 35 mm du film d’action hollywoodien Bangkok Dangerous (réalisé par les frères Pang en 2008), mettant en vedette nul autre que Nicolas Cage, dans le but de créer une performance où des projections 16mm s’entremêleraient avec des projections 3D, le tout accompagné d’une musique en direct qui prendrait comme source uniquement le son de la bande-annonce du film. Le projet s’inscrit donc à plusieurs égards dans une certaine tradition de cinéma de found footage. Nous avons voulu profiter des caractéristiques propres d’une bande-annonce de film, c’est-à-dire, saisir toute la palette d’émotions de Nicolas Cage synthétisée en deux minutes et 30 secondes pour en faire une création de plus ou moins 25 minutes, composée entièrement de moments d’intensité brute, d’actions pures sans aucun souci de psychologie. Bangkok loops, c’est voir Nicolas Cage tuer, fuir, séduire, aimer, en rafale.

Emprunter les voies du found footage, c’était aussi une façon de passer au-dessus notre crainte de répéter tout ce qui s’était déjà fait précédemment dans un cinéma dit d’avant-garde ou expérimental. Comme si s’aventurer sur des territoires maintes fois arpentés offrait une énergie à se dépasser, à trouver quelque chose de nouveau, du moins, à essayer.

Une 3D créée de toutes pièces

L’un des moteurs créatifs derrière la performance est sans aucun doute ce désir d’hybridité entre un cinéma en pellicule et en numérique. Il y a un réel souci de créer quelque chose « d’unique, propre à notre époque », en raison des avancées technologiques. C’est ainsi qu’est apparue une partie de notre intérêt pour la trois dimensions. Cette technologie nous attirait également, étant donné sa grande popularité et le manque de propositions audacieuses dans le circuit des cinémas traditionnels (exception près du film de Jean-Luc Godard Adieu langage.).

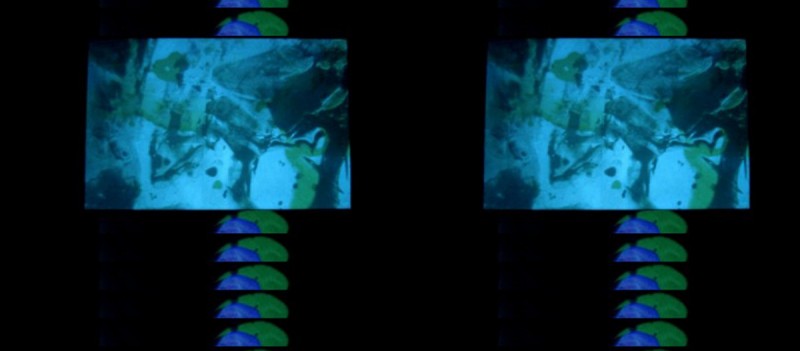

[RAPHAËL] Pour créer la troisième dimension, je devais trouver une solution alternative à la 3D active qui est la méthode la plus répandue sur le marché pour les cinémas maison, mais qui est simplement irréaliste pour une projection devant plus d’une cinquantaine de personnes. Une seule paire de lunettes active peut couter environ 60 $ tandis qu’on peut obtenir une paire de lunettes passive pour seulement 0.75 $. Je n’avais d’autre choix que de choisir la technique passive qui consiste à polariser la lumière afin de séparer les deux images projetées. Deux projecteurs vidéo standard et quelques paires de lunettes passives ont été agencés pour créer le premier dispositif de projection.

Pour que la 3D fonctionne, la surface de projection devait être adaptée. Une toile blanche standard diffuse la lumière de façon imprévisible, pour la 3D passive, la surface de projection doit diffuser la lumière en gardant sa polarité, une propriété qui n’appartient qu’aux métaux. Nous devions trouver un vrai Silver Screen.

Personne ne loue ce genre d’écran à Montréal, on ne peut supposément pas les rouler pour le transport et il semblerait que personne, à part nous, n’en ait vraiment besoin ! Nous devions soit en construire un, soit trouver une alternative. Pour commencer à expérimenter rapidement, j’ai bêtement collé une petite feuille d’aluminium (2’×4’) grossièrement polie sur un dessus de table IKEA fixé au mur. La 3D fonctionnait, mais à petite échelle. Quelques points blancs sur un fond noir dessinés dans le logiciel Paint suffisaient à le confirmer, mais la surface était loin d’être optimale. Les reflets causés par les imperfections nuisaient beaucoup au visionnement.

Ils apparaissaient plus brillants que l’image projetée et les yeux tentaient de focaliser sur ces imperfections. Vu l’absence et la rareté de la surface parfaite, nous étions contraints à utiliser cette surface pour générer le contenu 3D jusqu’à ce que l’on trouve une meilleure surface de projection : un réflecteur géant lamé silver de 20’×20’. Une surface loin d’être parfaite, mais beaucoup plus efficace qu’une feuille d’aluminium si elle est bien tendue.

Afin de conserver l’idée du found footage altéré chimiquement, j’entrepris la conception d’un programme Processing qui me permettrait d’utiliser les vidéos que Charles-André me fournirait pour les déplacer à ma guise dans « la troisième dimension ». Un programme assez simple qui superposerait la même image sur l’écran d’aluminium en y appliquant un léger décalage horizontal en fonction du déplacement désiré. Quand l’image polarisée pour l’oeil gauche se dirige vers la droite et que l’image de l’oeil droit se déplace vers la gauche, on obtient une seule image flottant devant l’écran. Si l’on inverse le décalage, on obtient une image qui semble être derrière l’écran.

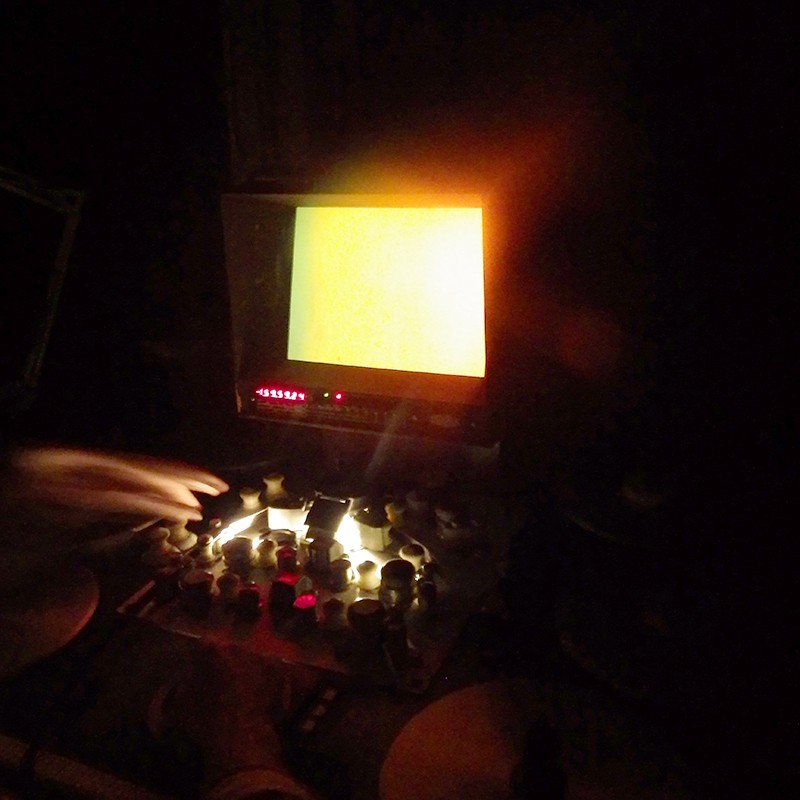

En parallèle, avec la programmation du Sketch Processing pour Bangkok Loops, j’avais envie de me fabriquer un contrôleur sur mesure afin de pouvoir modifier les paramètres de profondeur et d’effets sans avoir les mains attachées au clavier au moment de la performance. J’ai donc créé mon propre Arduino Uno. Pour ce faire, j’ai réuni une boîte en bois trouvée à la boutique Renaissance, quelques composantes électroniques et un fer à souder à la main : la Bangkok Box venait de prendre forme ! Cette boîte couverte d’interrupteurs, de potentiomètres et de lumières s’avère être des plus utiles pour les manipulations en direct.

La profondeur, la position et les effets liés à la troisième dimension, tout devait être programmé préalablement. Après quelques centaines de lignes de code, tout semblait fonctionner. Le programme s’exécutait fluidement, offrait de sauvegarder tous les paramètres afin de les restaurer instantanément lors de la performance. Les effets étaient assignés au contrôleur et tout était en 3D, mais pour ce genre de projet, aucun ordinateur ne semble assez performant le moment venu… Afin d’être fluide, le programme doit tout charger en mémoire avant de commencer à afficher quoi que ce soit, un processus qui peut prendre quelques minutes si on importe plusieurs centaines de mega-octets de vidéo HD. Dans le but d’optimiser le développement du code, j’avais limité le nombre de clips vidéo à trois puisque, pour ce genre de programmation, on passe assez souvent de l’écriture du code à l’exécution du code pour voir si nos modifications fonctionnent, alors on ne veut pas perdre trop de temps dans le chargement de fichiers. La programmation étant terminée, à une journée de notre performance au FNC, il était temps de lier tous les clips vidéo au programme. Il s’agissait de 3GB de données à gérer en temps réel et plus rien ne fonctionnait. Les fichiers vidéo étaient trop volumineux et le nombre d’images par seconde oscillait entre 1 et 3. Peut-être une mauvaise gestion de fichiers dans le code, peut-être une limitation technique de Processing… le programme devait être fluide pour la performance alors tous les vidéos devaient être compressés… rapidement! Environ une heure avant la performance, nous avions une dizaine de vidéos de taille raisonnable fraîchement compressées pendant que nous nous installions. Juste assez de clips pour pouvoir jouer avec le programme pendant les 25 minutes que durait la performance.

De plus, voyant la captation vidéo de notre performance, il nous apparaît évident que notre désir de générer de la trois dimensions allait dans le même sens que notre idée du live. Une partie resterait invisible, éphémère à la projection vécue avec les lunettes lors de la présentation.

Modification du matériel 35mm original

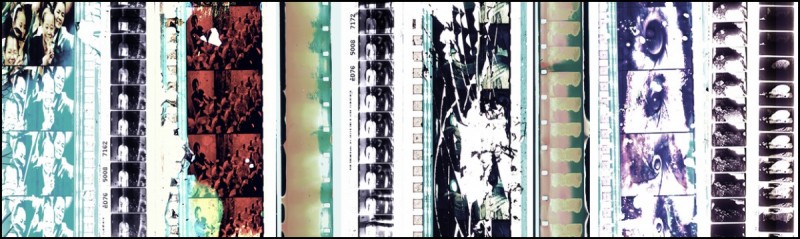

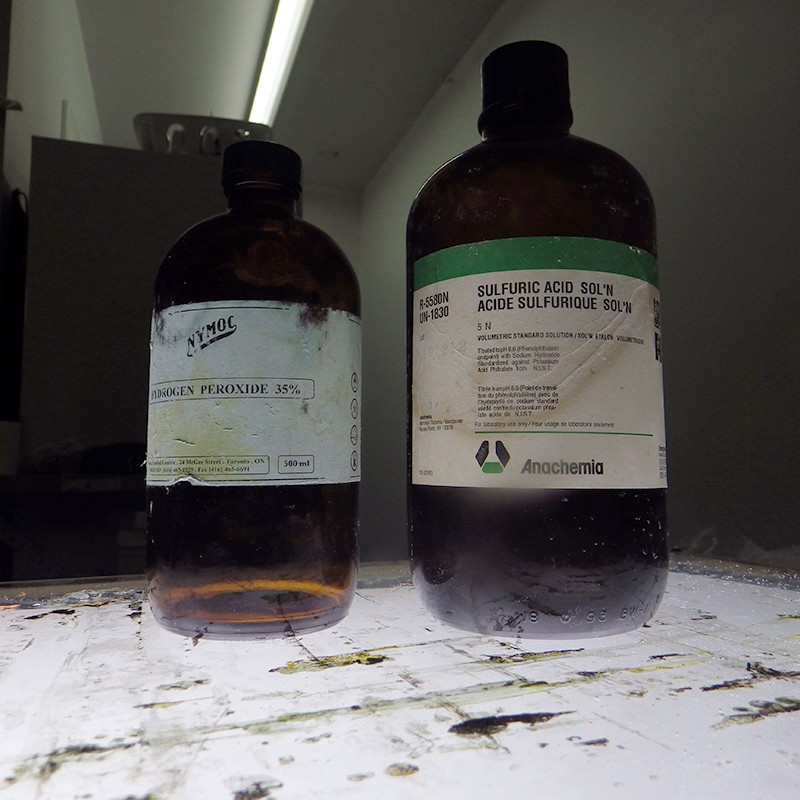

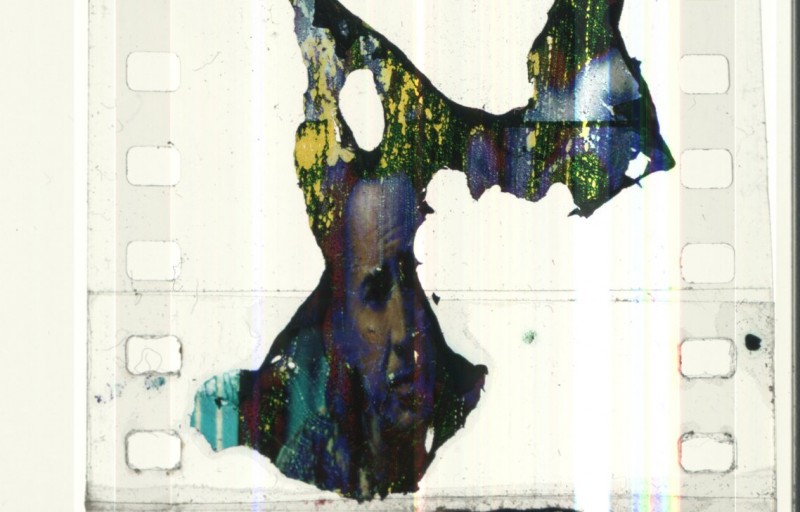

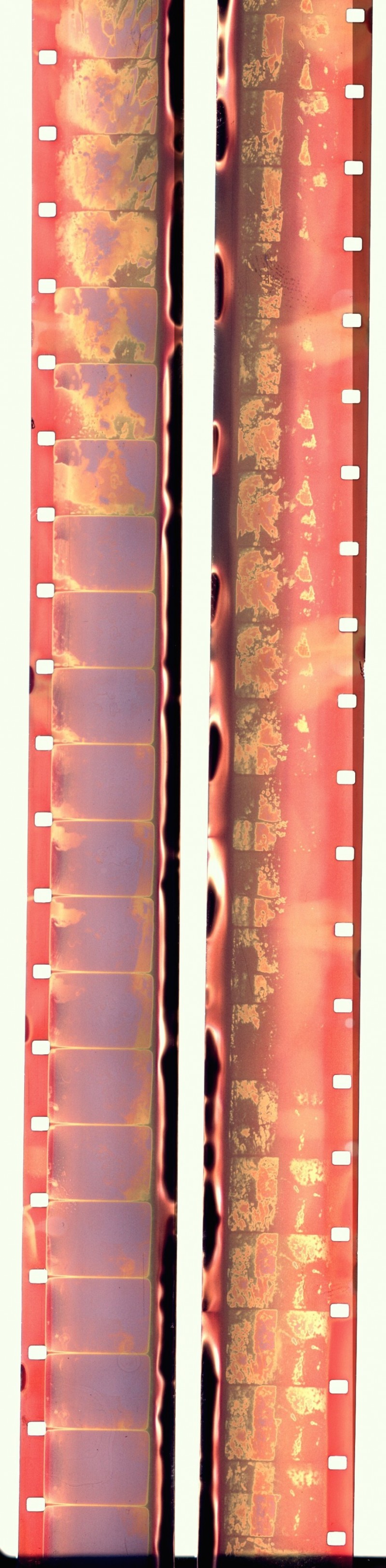

[CHARLES-ANDRÉ] Concernant le travail sur la pellicule, la première étape consiste à « magnifier » le matériel de base par divers procédés chimiques : faire bouillir la pellicule à haute température avec des cristaux de soude, lui faire goûter une pointe d’acide sulfurique – allant jusqu’à faire fondre mes bottes de cuir et exploser la bouteille de solution! Comme quoi on peut encore avoir les mains sales à faire du cinéma.

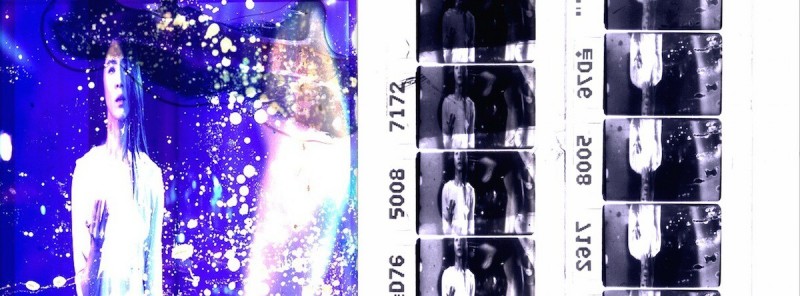

Une fois la bande annonce 35 mm entièrement altérée, c’est avec l’aide d’une amie directrice photo, Isabelle Stachtchenko Sirois, que l’on a refilmé en HD (avec la Pocket Black Magic) les images défilant sur une table de montage Steenbeck 35 mm à l’atelier de Double Négatif. Avec les images numérisées, l’étape suivante consistait à faire un montage sur Final Cut Pro des images afin de créer des séquences que Raphaël allait « transformer » en trois dimensions par la suite.

Techniques de refilmage

Premièrement, il y a eu le refilmage sur la Steenbeck 35mm. Dans cette première étape, il y avait, d’une part, l’intention de numériser les images pour le travail qui allait suivre en 3D, et, d’autre part, le but d’enregistrer des manipulations avec la pellicule, par exemple, mes mains qui placent la pellicule sur le mécanisme de la Steenbeck. Nous avions cette volonté de jouer avec ce rapport de « manipulations enregistrées » qui seraient projetées, par la suite, en direct lors de la performance.

Deuxièmement, il y a eu plusieurs tests de refilmage avec un écran d’ordinateur iMac. Je refilmais les images 35mm numérisées à l’aide d’une caméra Bolex 16mm en noir et blanc (pellicule Tri-X et High Contrast) et en couleur (pellicule 200D Wittner et du Print Stock). Il manquait nettement de luminosité aux images numérisées, ce qui a créé des images à faible contraste dans le cas de la pellicule Tri-X et 200D ou des images sous-exposées dans le cas de la High-Contrast et du Print Stock couleur.

Malgré tout, une bonne partie du matériel en 16mm présenté lors de la performance provient de cette technique, bonifié par des effets lors du développement en fonction de la température des bains notamment.

Bien que cette envie de mêler les deux médiums filmiques à l’étape de la production du matériel n’ait pas été tout à fait concluante, elle m’apparaît toujours comme une avenue à explorer. De plus, je peux mentionner que quelques séquences 16mm ont été développées, selon la technique du « Chromaflex » telle qu’enseignée par le cinéaste australien Richard Tuohy, qui permet de développer sur une même bande de l’image couleur et noir et blanc.

Troisièmement, il y a eu une série de refilmages réalisée à Vision Globale grâce au directeur du laboratoire Alban Berg qui m’a fait découvrir une visionneuse/projecteur 35 mm qui servait autrefois aux étalonneurs de cinéma. En résumé, cette machine projette avec une puissante intensité lumineuse une bobine 35mm dans le but de voir les couleurs correctement et de faire des ajustements en conséquence. J’ai donc refilmé la bande-annonce 35mm de cette façon, à l’aide de ma caméra Bolex et d’une Super-8. Le résultat de ces images n’a pas été projeté lors de la performance, mais servira probablement pour de prochains événements.

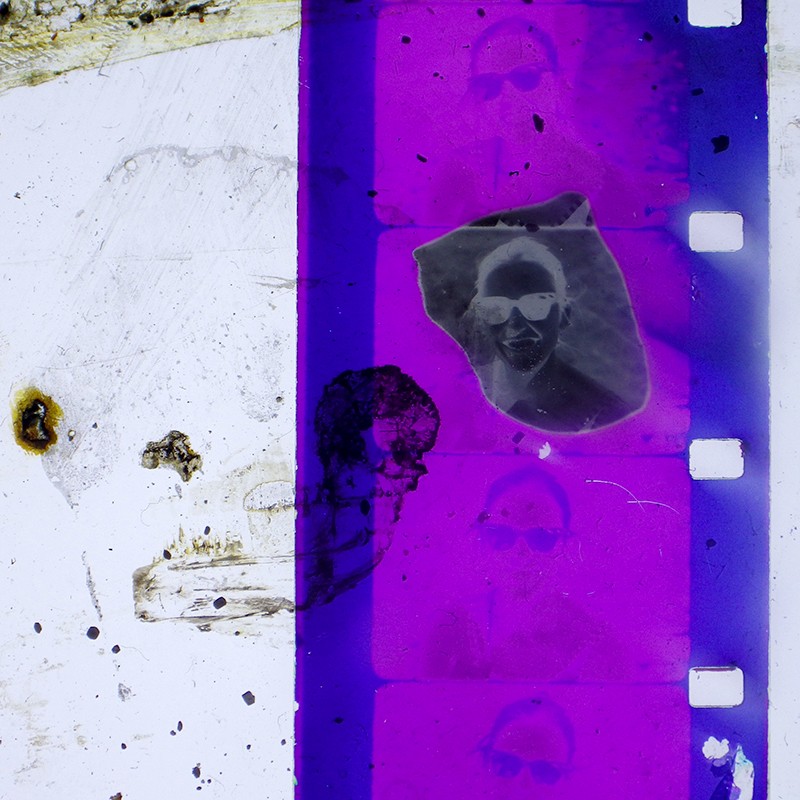

Finalement, il y a ce que l’on pourrait inclure sous le nom de « refilmage photoargentique ». J’ai procédé à du tirage contact à l’aide d’un agrandisseur photo afin de « photocopier » une partie de la bande image 35mm sur de la pellicule 16mm. Cette technique sera davantage utilisée pour la production de nouveaux matériels puisqu’elle préserve quelque chose de très organique à l’image (aucun passage par l’ordinateur) et surtout permet de créer un effet de double image intéressant puisqu’il faut deux bandes 16mm pour faire la largeur d’une pellicule 35mm.

De plus, j’ai littéralement collé des fragments d’images 35mm sur une bande 16mm transparente à laquelle j’ai ajouté des couches d’encres de chine et de peinture. Cette technique permettait de créer des images plus abstraites, mais avait le net désavantage de totalement ruiner le matériel d’origine. extrait

La bande-son

Un autre aspect très important à la création de Bangkok Loops est l’aspect sonore. Raphaël et moi avons abordé Roger Tellier-Craig pour participer à la performance une fois le projet enclenché.

[ ROGER] La matière sonore utilisée pour Bangkok Loops provient entièrement de la trame sonore de la bande-annonce du film Bangkok Dangerous. Tous les extraits musicaux et les dialogues de la bande-annonce furent soumis à un traitement d’échantillonnage et de granulation sonore, élaborant ainsi une banque de sons qui pouvaient ensuite être déclenchés et transformés en temps réel. Ainsi, la performance a été la première rencontre entre la matière image et la matière sonore.

Nous avions montré préalablement quelques échantillons de notre matériel image à Roger, et ce dernier nous avait fait parvenir quelques extraits audio. La performance est donc apparue comme une presque totale improvisation, d’autant plus que Raphaël a été aux prises avec quelques problèmes reliés à la capacité de son ordinateur.

La performance

[CHARLES-ANDRÉ] Lors de la soirée, j’utilisais 6 projecteurs 16mm avec, à ma disposition, près d’une quarantaine de boucles 16mm. Raphaël était muni de 2 projecteurs numériques, sa Bangkok box ainsi que de son ordinateur. Nous projetions sur une toile réfléchissante de 20 pieds x 20 pieds ainsi que sur deux plus petits écrans, des draps blancs mis au-devant de la toile, proposant une perspective en relief et permettant une meilleure qualité de projection pour les images 16 mm. La performance telle que présentée au FNC s’avère être la première étape d’un projet en création continue. Nous désirons continuer à explorer les spécificités du médium film et numérique, principalement en 3D (dans le cadre de ce projet) et peut-être, proposer une projection 16mm 3D lors de notre prochaine représentation.